"Es war eine Verkettung unglücklicher Zufälle." Diesen Satz hört und liest man oft im Zusammenhang mit Unfällen – auch in der Luftfahrt. Aber stimmt das wirklich? Ist es nicht vielmehr so, dass ein komplexes System wie die Luftfahrt grundsätzlich eine Vielzahl an potenziellen Möglichkeiten für Fehler bietet, und der einzige Zufallsfaktor ist, dass man nicht weiß, wo letztendlich der Fehler passiert?

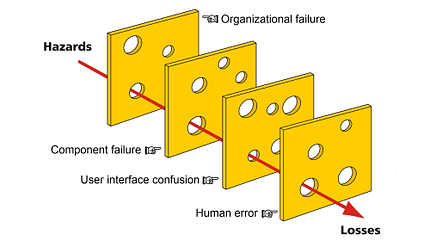

Der britische Psychologe James Tootle Reason, Professor an der Universität von Manchester, befasste sich Zeit seines Berufslebens mit dem Thema Human Factors. Ende der 1980er Jahre veranschaulichte er Fehlerketten mit hintereinander angeordneten Käsescheiben, die die Sicherheitsbarrieren eines Systems darstellten, und deren Löcher symbolisch für die Möglichkeit des Versagens der Barriere standen. Nur wenn alle Barrieren versagen, so Reasons Einschätzung, die Käsescheiben also Loch auf Loch stehen, kommt es zu einem Unfall. Denn auf diese Weise ergibt sich ein Pfad von der auslösenden Ursache bis hin zu den endgültigen und unerwünschten Folgen.

Das Schweizer-Käse-Modell zeigt, wie das Versagen mehrerer Sicherheitsebenen zum Unfall führt, wenn die Scheiben Loch auf Loch stehen.

Reason untersuchte im Rahmen seiner Forschung die Unfallberichte von Katastrophen wie die Reaktorunfälle in den Kernkraftwerken Three Mile Island und Tschernobyl, die Chemiekatastrophee von Bhopal, das Challenger-Unglück, den Brand in der Londoner Ubahnstation King’s Cross und den Untergang der niederländischen Fähre Herald of Free Enterprise und schlug schließlich eine Unterscheidung zwischen aktivem und latentem Versagen vor, das er später in eine Differenzierung zwischen Personen- und Systemfehlern überführte. Dabei vertrat er die die Hypothese, dass die meisten Unfälle auf einen oder mehrere von vier Fehlerbereichen zurückgeführt werden können, konkret auf organisatorische Einflüsse, (mangelnde) Aufsicht, Vorbedingungen und konkrete Handlungen. Latente Fehler des Systems seien lange vor einem widrigen Ereignis auf der Führungs- und Organisationsebene angelegt, bevor sie zusammen mit ungünstigen Umständen und durch unsichere Handlungen einzelner Personen – das aktive Versagen – zum Unfall führen.

Den Überlegungen Reasons lag dabei eine tiefgreifende Auseinandersetzung mit der Fehlbarkeit des Menschen zugrunde. In zwölf Punkten charakterisierte er das Thema Fehler und hielt fest, wie ein Umgang damit aus seiner Sicht erfolgen müsse, um eine Wiederholung zu vermeiden:

- Menschliches Versagen ist universell und unvermeidlich – es ist kein moralischer Fehler. Menschliche Fehlbarkeit kann zwar gemildert, aber niemals vollständig beseitigt werden.

- Fehler sind nicht grundsätzlich schlecht – Erfolg und Misserfolg haben dieselben psychologischen Wurzeln. Ohne Fehler wären Lernen und Kompetenzentwicklung sowohl in technischen als auch in nichttechnischen Bereichen unmöglich.

- Man kann die menschliche Natur nicht ändern, aber man kann die Bedingungen ändern, unter denen Menschen arbeiten – Fehlerfallen zu erkennen und ihre Merkmale zu verstehen ist entscheidend für ein effektives Fehlermanagement.

- Die besten Leute können die schlimmsten Fehler machen – niemand ist davor gefeit. Diejenigen, die hohe Verantwortung tragen, können Fehler mit erheblichen Konsequenzen begehen.

- Menschen können Handlungen, die sie nicht beabsichtigt haben, nicht einfach vermeiden – Einzelpersonen für ihre Fehler verantwortlich zu machen mag emotional befriedigend sein, ist aber ineffektiv für Korrekturmaßnahmen. Verantwortlichkeit bleibt jedoch entscheidend, um eine Wiederholung zu verhindern.

- Fehler sind Folgen, keine Ursachen – die Identifizierung eines Fehlers ist nur der Anfang, um seine Grundursachen zu verstehen, nicht das Ende. Nur durch die Analyse der Umgebungsbedingungen kann ein erneutes Auftreten verhindert werden.

- Viele Fehler folgen wiederkehrenden Mustern – die Konzentration auf diese Muster ist der effektivste Weg, um Fehler mit begrenzten Ressourcen zu bewältigen.

- Schwerwiegende sicherheitsrelevante Fehler können auf allen Ebenen eines Systems auftreten – menschliche Fehler sind nicht ausschließlich auf Frontline-Mitarbeiter beschränkt. Je höher jemand in einer Organisation steht, desto gefährlicher können seine Fehler sein.

- Beim Fehlermanagement geht es darum, das Kontrollierbare zu kontrollieren – während die menschliche Natur nicht verändert werden kann, können Situationen und Systeme effektiv gemanagt werden. Die besten Lösungen beinhalten technische, verfahrenstechnische und organisatorische Maßnahmen und nicht nur psychologische Ansätze.

- Das Fehlermanagement zielt darauf ab, gute Menschen zu hervorragenden zu machen – Leistungsträger antizipieren mental Reaktionen auf verschiedene Szenarien. Die Verbesserung der Fehlererkennung ist ebenso wichtig wie das Verständnis dafür, wie Fehler entstehen.

- Es gibt nicht nur einen einzigen besten Weg – unterschiedliche menschliche Herausforderungen erfordern unterschiedliche Strategien, und Organisationskulturen erfordern maßgeschneiderte Ansätze.

- Effektives Fehlermanagement konzentriert sich auf kontinuierliche Reformen, nicht auf isolierte Lösungen – die Fixierung auf einzelne Fehler ist ineffektiv. Der einzige Weg, um systemische Probleme zu lösen, besteht darin, das Umfeld zu reformieren, das sie ermöglicht.

Mit seinen Überlegungen zu Human Factors und zur Fehlerkultur leistete James Reason einen unschätzbaren Beitrag zur modernen Flugsicherheit und prägten die Entwicklung hin zu Crew Resource Management, Thread-and-Errror-Management und Safety Management Systems. Seine Erkenntnisse revolutionierten die Art und Weise, wie die Branche mit Sicherheit umgeht, und verlagerten den Fokus von rein technologischen und verfahrensbezogenen Lösungen auf Organisationskultur und menschliche Interaktion. Seine Arbeit hat zum Aufbau einer sichereren Luftfahrtindustrie beigetragen, indem sie proaktives Risikomanagement anstelle von reaktiven Reaktionen fördert.

Und das Käsescheibenmodell? Das ist bis heute ein probates Mittel, um Flugschülern die Abläufe in Fehlerketten im Theorieunterricht zu erklären.

Am 5. Februar ist James Reason im Alter von 86 Jahren gestorben.